오토파일럿 홈페이지 [번역]

우리는 규모에 맞는 자율성을 개발하고 배포합니다. 우리는 inference 하드웨어의 효율적인 사용으로 지원되는 비전 및 플래닝을 위한 고급 AI 기반의 접근 방식이 완전한 자율 주행에 대한 일반적인 솔루션을 달성 할 수있는 유일한 방법이라고 생각합니다.

하드웨어

소형 아키텍처 및 마이크로 아키텍처의 모든 개선 사항을 고려하면서 최대 와트 당 실리콘 성능을 높히기 위해 자체 구동 소프트웨어를 기본적으로 강화하는 실리콘 칩을 구축하십시오. 설계에 대한 floor-planning, 타이밍 및 전력 분석을 수행합니다. 강력하고 무작위 화 된 테스트 및 스코어 보드를 작성하여 기능 및 성능을 확인하십시오. 성능 최적화 및 절전에 중점을 두고 칩을 프로그래밍하고 통신하기 위해 컴파일러 및 드라이버를 구현합니다. 마지막으로 실리콘 칩의 유효성을 검사하여 대량 생산하십시오.

신경망

인식에서 제어에 이르는 다양한 문제에 대한 심층 신경망을 훈련시키기 위해 최첨단 연구를 적용합니다.

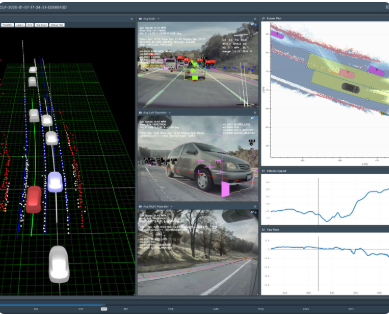

카메라 별 네트워크는 raw 이미지를 분석하여 시맨틱 세그먼테이션, 객체 감지 및 monocular depth 추정을 수행합니다. birds-eye-view 네트워크는 모든 카메라에서 영상을 가져와 도로 레이아웃, 정적 인프라 및 3D 객체를 top-down view로 바로 출력합니다. 우리의 네트워크는 세계에서 가장 복잡하고 다양한 시나리오에서 배우며, 거의 1 백만 대의 차량을 실시간으로 반복해서 얻습니다. Autopilot 신경망의 전체 빌드에는 48 개의 네트워크가 포함되며, 이를 훈련하는 데 70,000 GPU 시간이 걸립니다. 함께, 그들은 각 단계마다 1,000 개의 distinct tensors (predictions)를 출력했습니다.

자율(Autonomy) 알고리즘

세계를 high-fidelity 한 표현과 그 공간의 trajectories 를 플래닝함으로 만들어진 자동차를 운전하는 핵심 알고리즘을 개발하십시오. 이러한 표현을 예측하도록 신경망을 훈련시키기 위해 공간과 시간에 걸쳐 자동차 센서의 정보를 결합하여 정확하고 대규모의 ground truth data 를 알고리즘 적으로 생성합니다. state-of-the-art 기술을 사용하여 불확실한 상황에서 복잡한 실제 상황에서 작동하는 강력한 계획 및 의사 결정 시스템을 구축하십시오. 전체 테슬라 차량 규모에 맞게 알고리즘을 평가하십시오.

Code Foundations

Throughput, latency, 정확성 및 determinism 은 코드를 최적화하는 주요 지표입니다. 맞춤형 하드웨어와 긴밀하게 통합되어 가장 낮은 수준의 스택에서 오토 파일럿 소프트웨어 기반을 구축하십시오. 무선 업데이트over-the-air updates 를 지원하여 super-reliable bootloader 를 구현하고 사용자 정의 된 Linux 커널을 가져옵니다. 빠르고 메모리 효율적인 저수준 코드를 작성하여 센서에서 고주파수, 대용량 데이터를 캡처하고 중앙 메모리 액세스 대기 시간에 영향을 주거나 CPU주기에서 중요한 기능 코드를 고갈시키지 않으면 서 여러 소비자 프로세스와 공유 할 수 있습니다. 여러 시스템 온 칩에 분산 된 다양한 하드웨어 처리 장치에서 Squeeze and pipeline compute 해보세요.

https://www.tesla.com/ko_KR/autopilotAI?redirect=no

We develop and deploy autonomy at scale. We believe that an approach based on advanced AI for vision and planning, supported by efficient use of inference hardware is the only way to achieve a general solution to full self-driving.

Hardware

Build silicon chips that power our full self-driving software from the ground up, taking every small architectural and micro-architectural improvement into account while pushing hard to squeeze maximum silicon performance-per-watt. Perform floor-planning, timing and power analyses on the design. Write robust, randomized tests and scoreboards to verify functionality and performance. Implement compilers and drivers to program and communicate with the chip, with a strong focus on performance optimization and power savings. Finally, validate the silicon chip and bring it to mass production.

Neural Networks

Apply cutting-edge research to train deep neural networks on problems ranging from perception to control. Our per-camera networks analyze raw images to perform semantic segmentation, object detection and monocular depth estimation. Our birds-eye-view networks take video from all cameras to output the road layout, static infrastructure and 3D objects directly in the top-down view. Our networks learn from the most complicated and diverse scenarios in the world, iteratively sourced from our fleet of nearly 1M vehicles in real time. A full build of Autopilot neural networks involves 48 networks that take 70,000 GPU hours to train 🔥. Together, they output 1,000 distinct tensors (predictions) at each timestep.

Autonomy Algorithms

Develop the core algorithms that drive the car by creating a high-fidelity representation of the world and planning trajectories in that space. In order to train the neural networks to predict such representations, algorithmically create accurate and large-scale ground truth data by combining information from the car's sensors across space and time. Use state-of-the-art techniques to build a robust planning and decision-making system that operates in complicated real-world situations under uncertainty. Evaluate your algorithms at the scale of the entire Tesla fleet.

Code Foundations

Throughput, latency, correctness and determinism are the main metrics we optimize our code for. Build the Autopilot software foundations up from the lowest levels of the stack, tightly integrating with our custom hardware. Implement super-reliable bootloaders with support for over-the-air updates and bring up customized Linux kernels. Write fast, memory-efficient low-level code to capture high-frequency, high-volume data from our sensors, and to share it with multiple consumer processes— without impacting central memory access latency or starving critical functional code from CPU cycles. Squeeze and pipeline compute across a variety of hardware processing units, distributed across multiple system-on-chips.